Reinforcement Learning – Wenn der Roboter seine Balance sucht: Ein Erfahrungsbericht

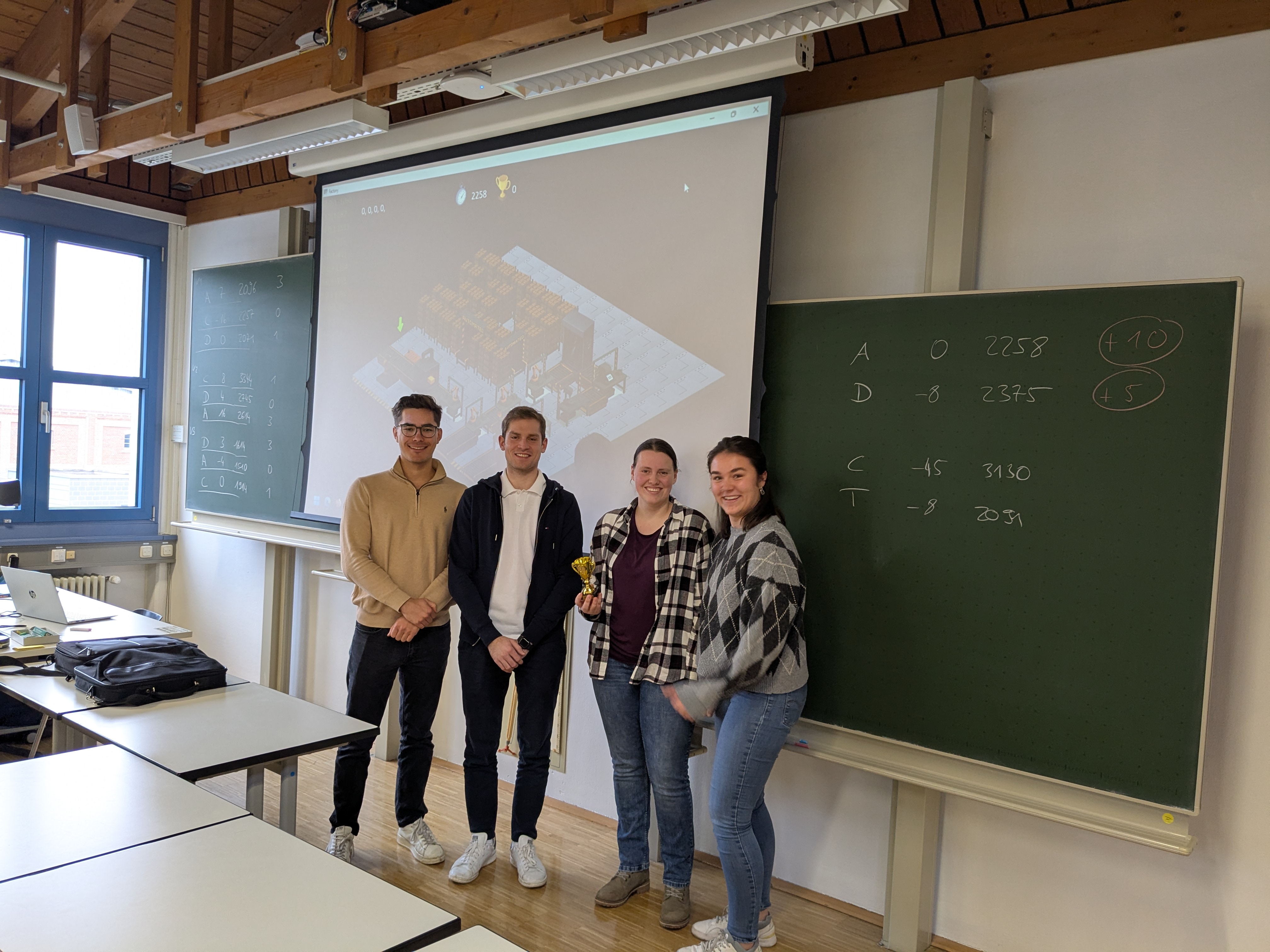

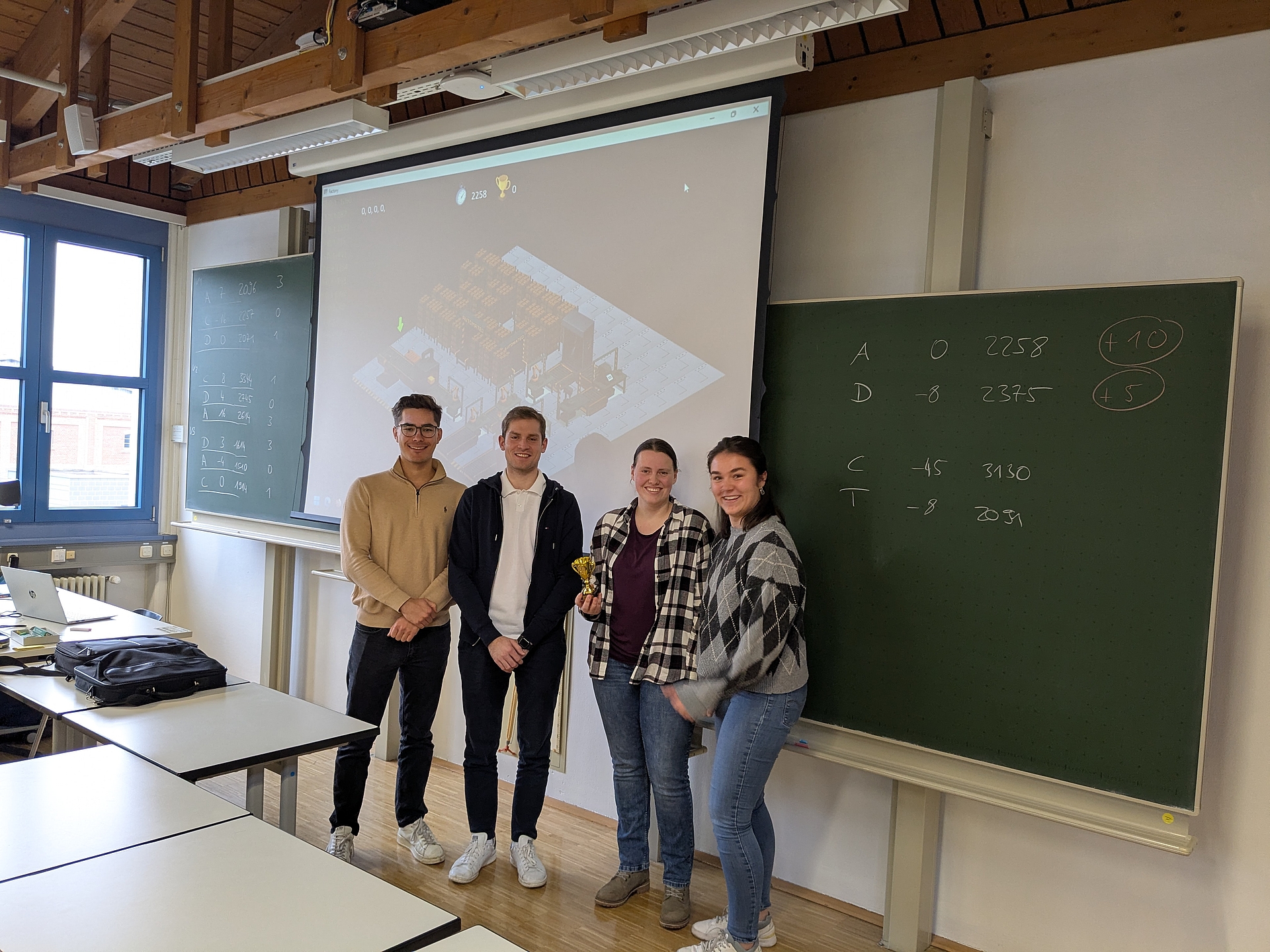

Im Rahmen der Vorlesung Data Science im Wirtschaftsingenieurwesen bei Herrn Prof. Dr. Teifel konnten die Studierenden des Kurses IPL23 an praxisnahen Beispielen umfangreiche Erfahrungen mit Reinforcement Learning sammeln:

Unsere Aufgabe: Ein autonomes Transportfahrzeug (AGV – Automated Guided Vehicle) und ein Lager in einer virtuellen Fabrik so zu trainieren, dass sie Material optimal zu den Fertigungsstationen transportieren. Es ging darum, den traditionellen starren Routenzug durch eine flexible, bedarfsgerechte Logistik zu ersetzen.

Die Aufgabe: Von starrer Logistik zur intelligenten Ressourcenverteilung

Die Kernidee unserer Aufgabe war, ein System zu entwickeln, in dem ein AGV und ein Lageragent lernen, eigenständig Entscheidungen für den Materialtransport zu treffen. Statt fester Fahrpläne sollten sie durch geschickte Belohnungsmechanismen dazu angeleitet werden, effizient und flexibel auf die Materialbedürfnisse der Stationen zu reagieren. Die Herausforderung lag darin, die KI nicht explizit zu programmieren, sondern ihr durch Belohnungen beizubringen, optimale Transportwege und -mengen zu wählen.

Der Lernprozess: Belohnungen, Rückschläge und neue Strategien

Zu Beginn zeigte unser AGV eine eher chaotische Fahrweise, ohne erkennbare Prioritäten oder ein Verständnis für die zugrundeliegenden Aufgaben. Es fuhr planlos durch das Lager, was uns schnell vor Augen führte, dass ein zielgerichtetes Training unerlässlich war – die Taktik, ein untrainiertes AGV und Lageragenten abzugeben, um sich Arbeit zu sparen, würde also nicht funktionieren; unser geschätzter Herr Professor würde wohl dahinterkommen.

Wir starteten mit Belohnungen, die das AGV für effizientes Verhalten incentivieren sollten. Zunächst versuchten wir es mit negativen Belohnungen für Fehlfahrten und stark negativen Anreizen für Fahrten ohne oder mit unzureichender Ladung. Die Reaktion des AGVs war unerwartet: Es tendierte dazu, stehen zu bleiben und seine Arbeit einzustellen – vermutlich, um Fehler und damit verbundene Bestrafungen zu vermeiden. Dieses Verhalten erinnerte frappierend an die Motivationslage eines dualen Studierenden am Freitagnachmittag, der das Labor lieber meidet, als etwas falsch zu machen.

Nach einer Anpassung der Belohnungsstruktur fuhr das AGV zwar wieder, zeigte aber eine Abneigung, die Teststation anzufahren, wo defekte Produkte abgeholt werden sollten. Eine positive Belohnung für das Anfahren dieser Station sollte Abhilfe schaffen. Das AGV lernte tatsächlich, die Station anzusteuern, doch nun fuhr es nach jedem Abladen dorthin, selbst wenn es keinen Sinn ergab. Wir hatten die positive Belohnung zu stark gewichtet und somit ein suboptimales Verhalten gefördert.

Immer wieder optimierten wir die Belohnungen: Negative Anreize für das Abweichen von der Strecke, positive für das Entladen von Ware und negative für Leerfahrten. Eine wesentliche Erkenntnis war, dass übermäßig hohe Belohnungen dazu führen können, dass sich der Agent in suboptimalen Verhaltensweisen festfährt oder seine Tätigkeit ganz einstellt. Es bedarf einer präzisen Abstimmung der Belohnungslandschaft, um die KI zu robustem und effizientem Verhalten anzuleiten.

Trotz mancher Frustration und des kontinuierlichen Feintunings gelang es unserer Gruppe schließlich, ein AGV und ein Lagersystem zu trainieren, die zwar nicht perfekt, aber eigenständig und harmonisch zusammenarbeiten. Diese Erfahrung hat uns nicht nur die Komplexität des Reinforcement Learnings nähergebracht, sondern auch gezeigt, wie sensibel und anspruchsvoll die Gestaltung von Belohnungsfunktionen für intelligente Agenten sein kann.

Vielleicht gilt diese Lektion ja nicht nur für Roboter: Mit der richtigen Balance zwischen Anreizen und Motivation findet man auch im Studium – und im Leben – seinen Weg. 😉

Rolf Ernst (WIWIPL23)